Бывает, что страницы перестают конвертировать продажи, происходит снижение трафика. Это значит, что они выпадают из индексации поисковыми системами. Если такое было замечено единожды, ничего страшного. Но если страницы выпадают постоянно, необходимо возвращать позиции сайта. Оперативная реакция на появившуюся проблему поможет избежать неприятных результатов.

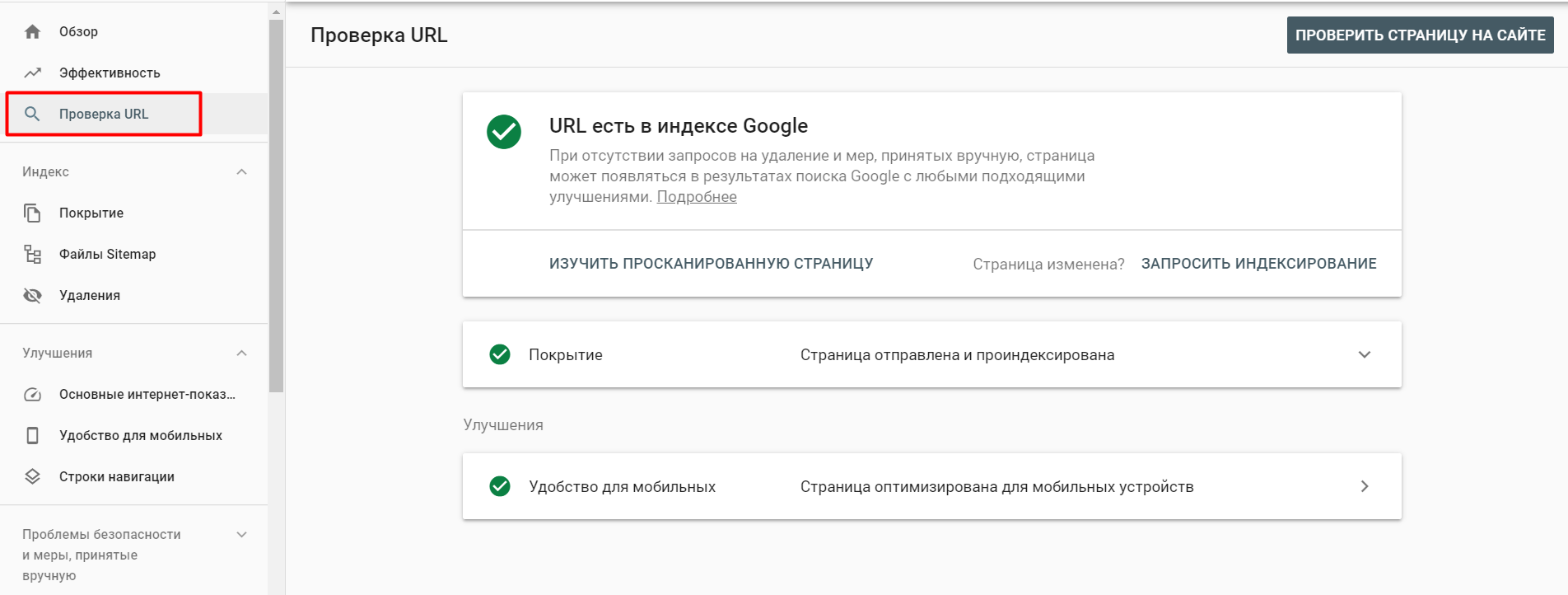

Google Search Console поможет проверить, не пропала ли страница из индексации поисковой системой.

Поисковики строго следят за сохранением авторского права. Если на странице есть не уникальный контент, то на веб-ресурс могут быть наложены санкции поисковыми роботами. Из-за этого сайт будет исключен из поиска. Чтобы этого не произошло, необходимо проверять размещенные тексты. Мы используем различные сервисы для проверки уникальности текстов, например, text.ru или advego.

Если на сайте нет полезной информации и он используется только для активного ведения рекламной кампании и продажи ссылок, ресурс будет иметь проблемы с индексированием.

Лучшее решение – подготовка качественного контента и наполнение страниц только полезной для пользователей информацией.

В текстах, которые пишутся для поисковых систем, есть большое количество ключевых фраз. Такие тексты порою бесполезны для клиентов, поэтому они пропадают из результатов в поисковиках.

Некоторые используют черные методы продвижения – размещают прозрачный текст с ключевыми словами. Это не повлияет на ранжирование сайта в поиске позитивно. Единственный вариант – проработать контент самостоятельно и создать уникальные тексты.

Страницы могут не попадать в поиск по некоторым другим проблемам, среди которых:

Дублирующиеся страницы отрицательно влияют на продвижение сайта. Это связано с тем, что поисковые роботы не так хорошо ранжируют ресурсы с одинаковыми текстами. Наличие повторяющегося контента приведет к выпадении страницы из индекса.

Чтобы проверить дубликаты, достаточно использовать оператор «site:». Но такой поиск не подойдет для больших сайтов. В таком случае стоит использовать сервисы для проверки дубликатов. В качестве решения проблемы используется тег «rel=canonical» или настройка 301 редиректа для дублирующихся страниц. Также можно просто удалить дубликаты.

Работа поисковых роботов направлена на демонстрацию пользователям качественного контента. Если на сайте плохое юзабилити, слишком навязчивая реклама, большое количество всплывающих окон – на страницы будут накладываться санкции.

Пользователи хотят доверять веб-ресурсам. Особенно, если речь идет о магазинах либо сайтах, предоставляющих какие-либо услуги. Наличие контактных данных, гарантийной информации, данных о покупке позволит повысить ранг сайта. Поэтому на страницах должны быть только правдивые сведения.

Одним из важных факторов, влияющих на ранжирование, является ссылочная цитируемость. Большое число купленных ссылок и ресурсов за малый промежуток времени, бесконтрольная продажа ссылок ведут к проблемам с ранжированием. Это связано с тем, что поисковые роботы не приемлют подобных методов продвижения и убирают такие сайты из поиска. Поэтому к стратегиям по закупке ссылок стоит подходить ответственно и готовить их перед началом продвижения сайта.

Фильтры могут накладываться по разным причинам. Вышеперечисленные нарушения могут привести к выпадению сайта из поиска по причине санкций, но это не все проблемы. Search Console позволяет вовремя отслеживать актуальные проблемы веб-ресурса.

Если сайт перестал отображаться в поиске, необходимо проверить его с помощью специальных инструментов, а позже – обратить внимание на чек-лист и выяснить, может на сайте есть:

В заключении стоит отметить, что для корректной работы сайта его необходимо регулярно проверять. В интернете для этой цели можно найти множество инструментов. Если проблемы с ресурсом решить на этапе их возникновения, можно избежать санкций и других неприятных последствий.

Оставьте ваш e-mail, чтобы получать подборки наших новостей.